自然言語処理(NLP)は、人工知能分野全体で変革的な力となり、技術との相互作用の仕方を根本的に再構築しています。この記事では、AIアプリケーションの進化をけん引する六つの革新的な NLP model の複雑さを探究し、これらのモデルのアーキテクチャ、方法論、およびパフォーマンスに深く踏み込むことで、NLPとAIの拡大する景観への貢献を包括的に理解することを目指します。

1. BERT: 自然言語処理の革命

Bidirectional Encoder Representations from Transformers、通称BERTは、自然言語処理(NLP)の領域での画期的な成果となっています。Jacob Devlin、Ming-Wei Chang、Kenton Lee、Kristina Toutanovaによって2018年に開発され、BERTは11以上の一般的な言語タスクを柔軟かつ優れた性能で処理することができます。以下で詳細を見てみましょう。

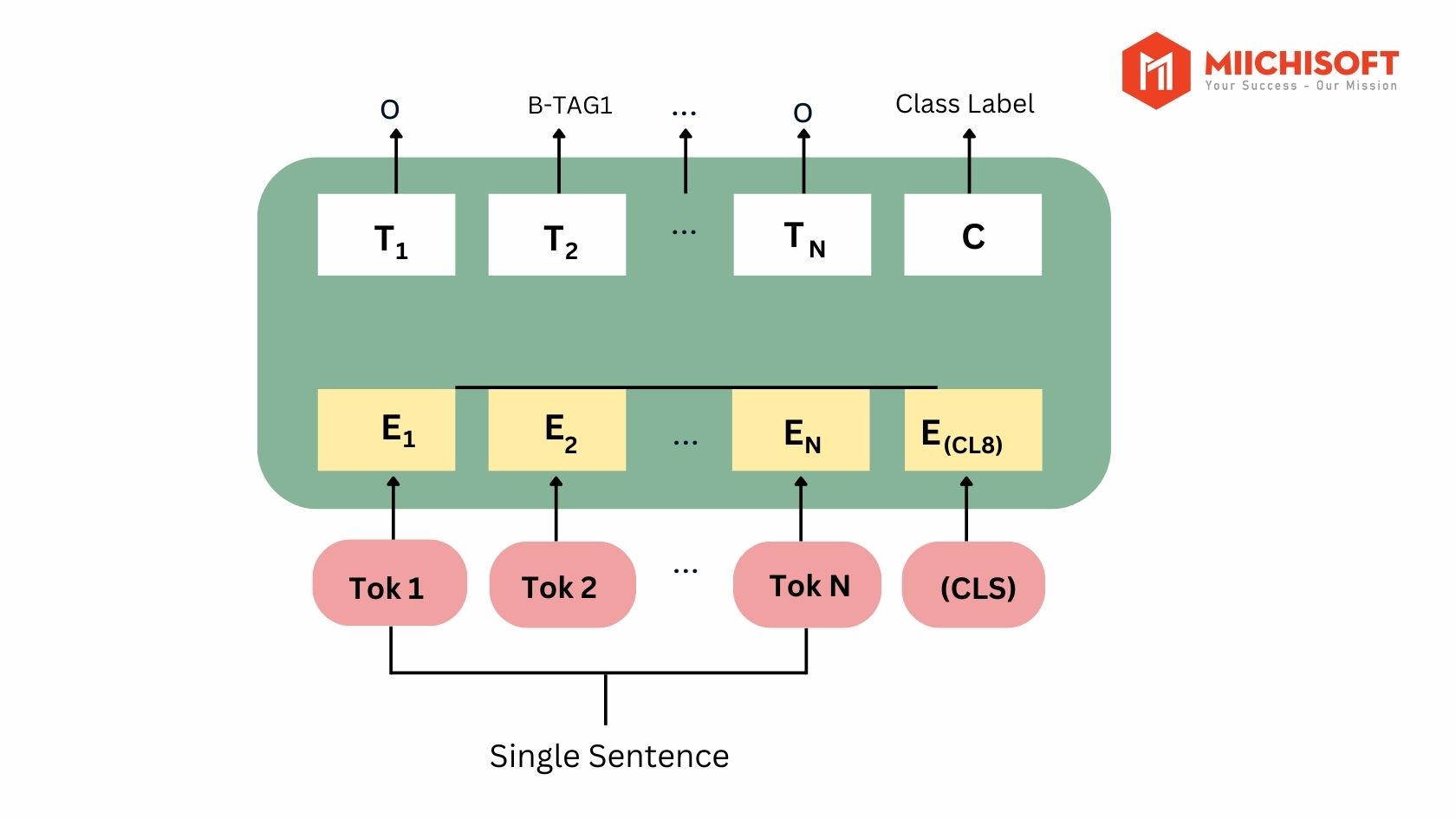

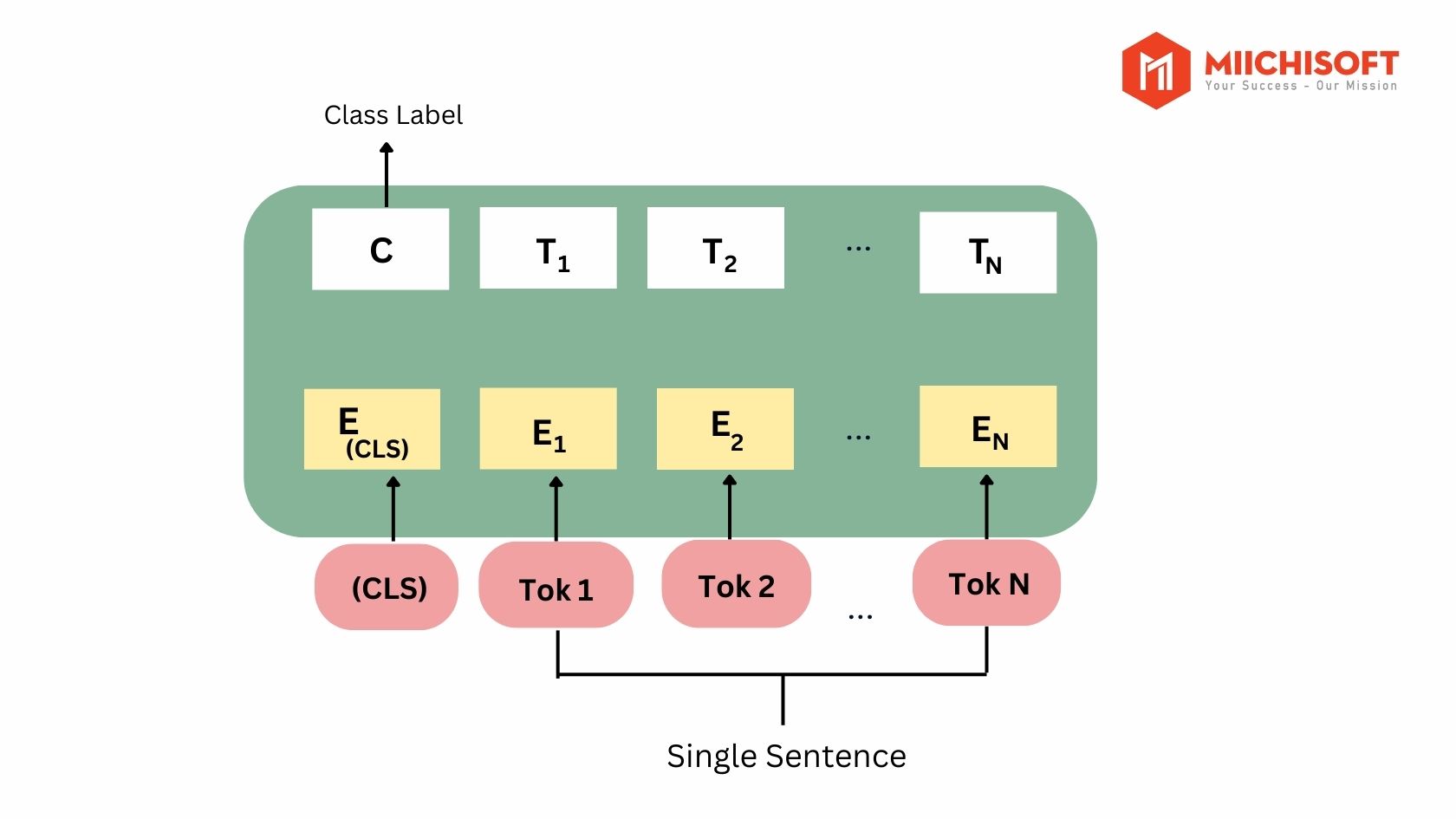

双方向のコンテキストの理解:

最近の言語表現モデルとは対照的に、BERTはすべてのレイヤーで左右のコンテキストを考慮して深い双方向表現を事前学習することに焦点を当てています。このユニークなアプローチにより、BERTは言語の微妙なニュアンスと複雑さをより包括的に捉えることができます。

微調整と適応性:

BERTの注目すべき特徴の一つはその適応性です。事前学習されたBERT表現は、わずか1つの出力層の追加で微調整が可能であり、さまざまなタスクのための先端モデルの作成を実現しています。この適応性は、重要なタスク固有の変更なしに質問応答や言語推論などのアプリケーションにも拡張されます。

データドリブンの成功:

BERTの成功の大部分は、33億語から成る広範なデータセットに起因しています。具体的にはWikipedia(25億語)とGoogle BooksCorpus(8億語)でトレーニングされたこの巨大なデータセットは、BERTが英語だけでなく、より広範な世界の理解に貢献しています。

概念的な単純さ、経験的な力:

概念的にはシンプルでありながら経験的に強力なBERTは、11のNLPタスク全体で最先端の結果を達成しています。注目すべき成果には、GLUEベンチマークでの80.4%のスコア、以前の結果に対する7.6%の絶対的な改善が含まれます。さらに、BERTはSQuAD 1.1の質問応答で93.2%の正確度を達成し、人間のパフォーマンスを2.0%上回っています。

BERT の主なパフォーマンス:

- BERTは、重要なアーキテクチャの変更を必要とせずにさまざまなNLPタスクにシームレスに適応する事前学習モデルを導入しています。

- BERTは11のNLPタスクにおいて最先端の技術を展示し、印象的な80.4%のGLUEスコア、7.6%の絶対的な改善を示しています。

- BERTは優れた精度を実現し、SQuAD 1.1の質問応答で93.2%の正確度を達成し、人間のパフォーマンスを2.0%上回っています。

2. XLNet: 自己回帰事前学習による言語理解の先進

XLNetは、Zhilin Yang、Zihang Dai、Yiming Yang、Jaime Carbonell、Ruslan Salakhutdinov、およびQuoc V. Leによる「XLNet: Generalized Autoregressive Pretraining for Language Understanding」で提案され、自然言語処理(NLP)の分野での重要な進歩を象徴するものです。

事前学習の自己回帰法:

XLNetはTransformer-XLモデルの拡張であり、自己回帰事前学習法を使用しています。この手法は、入力シーケンスの因子化順序のすべての順列にわたって期待される尤度を最大化し、XLNetに双方向コンテキストでの学習を可能にしています。この新しい手法は他のモデルの制約を克服し、XLNetの有効性に寄与しています。

一般化された自己回帰事前学習:

一般化された自己回帰事前学習法として、XLNetは因子化順序のすべての順列にわたって期待される尤度を最大化することで、双方向学習において優れた結果を生み出します。その自己回帰的な定式化により、XLNetは他のモデルにはない深い言語の微細な側面を捉えることができます。

Transformer-XLのアイデアの統合:

XLNetは、Transformer-XLのアイデアを事前学習プロセスに統合しています。この統合により、モデルの能力が向上し、さまざまなNLPタスクで優れたパフォーマンスを発揮しています。

BERTに対する経験的な優位性:

経験的な結果は、XLNetがさまざまなNLPタスクでBERTを上回ることを示しています。20以上のタスクでBERTをしのぎ、しばしば著しい差をつけてXLNetはNLP分野で堅牢な競争相手として確立されています。質問応答、自然言語推論、感情分析、文書ランキングなど18のタスクで最先端の結果が達成されています。

XLNetの主な実績:

- XLNetは質問応答、自然言語推論、感情分析、文書ランキングなど18のNLPタスクで一貫して他のモデルを上回っています。

- BERTに対して優越性を発揮し、XLNetはさまざまなタスクで著しいパフォーマンス向上を達成し、NLPの先進モデルとしての地位を強化しています。

3. RoBERTa: BERTを大幅に最適化した進化

RoBERTa(Robustly Optimized BERT Pretraining Approach)は、自然言語処理(NLP)における強力な進化として登場しています。Yinhan Liu、Myle Ott、Naman Goyal、Jingfei Du、Mandar Joshi、Danqi Chen、Omer Levy、Mike Lewis、Luke Zettlemoyer、およびeselin Stoyanovのチームによって作成され、RoBERTaはBERTモデルの堅牢な最適化を表しています。RoBERTa についてさらに理解するには、以下をお読みください。

多様なパフォーマンスの向上:

RoBERTaは、一連の最適化を通じて、トレーニングの期間を延長し、より大きなバッチで、より多くのデータで、次の文予測目標を取り除き、より長いシーケンスでトレーニングし、トレーニングデータに適用されるマスキングパターンを動的に変更するなど、すべてのpost-BERTメソッドと同等またはそれ以上の性能を発揮します。

データの制御と大規模データセットの作成:

トレーニングセットサイズの影響を緩和するために、RoBERTaは包括的なアプローチを採用しています。先進的なトレーニング手順だけでなく、他の広く使用されているデータセットと同等の規模である包括的な新しいデータセットであるCC-NEWSも収集します。トレーニングデータが慎重に制御されると、RoBERTaの改良されたトレーニング手法は、GLUEやSQuADなどのベンチマーク評価で一貫してBERTの発表された結果を上回ります。

GLUEベンチマークでの成果:

RoBERTaは、General Language Understanding Evaluation(GLUE)ベンチマークで新しい基準を確立します。最近導入されたXLNetモデルと同等の性能を発揮するだけでなく、9つの個々のタスクのうち4つで新しい最先端のパフォーマンスを確立します。これは、RoBERTaの多様なNLP課題に対する柔軟性と効率を強調しています。

RoBERTaの主な実績:

- GLUEベンチマークでは、新しいモデルは最近導入されたXLNetモデルと同等の性能を発揮し、9つの個々のタスクのうち4つで最先端の成果を確立します。

- RoBERTaはGeneral Language Understanding Evaluation(GLUE)ベンチマークのすべての個々のタスクでBERTを上回り、NLPランドスケープでの優れたモデルとしての地位を確認しています。

4. ALBERT: 軽量自己教師あり言語表現学習のアプローチ

ALBERT(Lite BERT for Self-supervised Learning of Language Representations)は、Zhenzhong Lan、Mingda Chen、Sebastian Goodman、Kevin Gimpel、Piyush Sharma、およびRadu Soricutによる革新的な開発です。これは、事前学習された言語モデルの増大するサイズによって引き起こされる課題に対する解決策として登場し、メモリ制約、長いトレーニング時間、そして時折予期せぬパフォーマンスの低下などの問題に対処しています。

モデルサイズの課題への対応:

ALBERTは、事前にトレーニングされた言語モデルの増大するサイズに対する課題への対応として、Google Researchチームによって提案されました。この成長により、メモリの制約、長期のトレーニング時間、そして時折パフォーマンスの低下といった実用的な課題が生じました。

パラメータ削減の手法:

ALBERTは、2つの革新的なパラメータ削減手法、つまり因子分解埋め込みパラメータ化とクロスレイヤーパラメータ共有を採用しています。これらの戦略は、より効率的なモデルアーキテクチャに寄与し、広範なモデルパラメータに関連する問題を軽減します。

文間の一貫性向上:

パラメータ削減に加えて、ALBERTは文の順序予測のための自己教師あり損失を導入し、文間の一貫性を向上させています。この手法は文間の関係の理解を向上させ、モデルの言語表現をさらに洗練させることを目指しています。

卓越したベンチマークの成績:

実験結果は、最適化されたALBERTがGLUE、RACE、およびSQuADなどの注目すべきベンチマークで新しい最先端の成績を達成していることを示しています。特筆すべきは、ALBERTがBERT-largeよりも少ないパラメータを使用してこれを達成しており、リソース利用の効率を示しています。

ALBERTの主な成績:

- より大規模なALBERT構成は、BERT-largeよりも少ないパラメータを使用して、現行の最先端の言語モデルを上回ります。これにより、RACEベンチマークでの優れた精度(89.4%)、SQuAD 2.0ベンチマークでのF1スコア(92.2%)、およびGLUEベンチマークでのF1スコア(92.2%)が達成されます。

- ALBERT構成は、元のBERT-largeモデルと比較して18のパラメータが少なく、1.7倍の高速トレーニングを実現しつつ、わずかに劣ったパフォーマンスを示します。これは導入されたパラメータ削減手法の有効性を強調しています。

5. PaLM: パスウェイズを活用した言語モデリングのスケーリング

PaLM、またはパスウェイズを活用した言語モデリングは、言語モデリングの分野における画期的な成果を代表しています。Aakanksha Chowdhery、Sharan Narang、Jacob Devlin、Maarten Bosma、Gaurav Mishra、Adam Roberts、Paul Barham、およびHyung Won Chungによって開発されたPaLMは、5400億のパラメータを備えた密なデコーダー専用のTransformerモデルで、革新的なPathwaysシステムを使用してトレーニングされています。

Pathways Language Modelの概要:

Pathways Language Model(PaLM)はその巨大なサイズで区別され、5400億のパラメータで構成されています。この密なデコーダー専用Transformerモデルは、アクセラレータ向けに分散計算を編成するPathwaysシステムと共に設計されました。この設計により、PaLMは複数のTPU v4 Pods上でトレーニングでき、大規模なトレーニングにおけるその拡張性と効率を示しています。

PaLMでのブレークスルー:

数百の言語理解および生成タスクで行われた実験は、PaLMの画期的な能力を示しています。特に、PaLMは言語理解、言語生成、推論、およびコード関連のチャレンジを含む様々なタスクで最先端のfew-shotパフォーマンスを達成しています。このモデルが要求の厳しいタスクで優れたパフォーマンスを発揮することは、その多様性と堅牢性を強調しています。

PaLMの主な成績:

- パフォーマンス向上のためのスケーリング: 数多くの実験では、チームが最大のモデルにスケールアップするにつれて、PaLMのパフォーマンスが著しく向上しました。

- 地球を揺るがすタスクのパフォーマンス: PaLM 540Bは、言語理解と生成、推論、およびコード生成を含む非常に困難なタスクのさまざまな面で画期的なパフォーマンスを達成しています。このモデルがこれらの多岐にわたる領域で優れたパフォーマンスを発揮することは、複雑な言語関連のタスクを処理する能力を示しています。

6. GPT-3: 生成型事前トレーニングTransformer 3

Generative Pre-trained Transformer 3、通称GPT-3は、深層学習技術を活用して人間のようなテキストを生成する自己回帰型言語モデルです。このモデルは自然言語処理の分野での重要な進歩を象徴しています。

タスクの複雑さへの対処:

様々な可能なタスクとそれぞれのタスクに大規模なラベル付きトレーニングデータセットを収集する難しさを考慮し、研究者たちは新しいアプローチを提案しました。その解決策は、タスクに依存しないfew-shotパフォーマンスを向上させるために言語モデルをスケーリングアップすることでした。このアプローチは、GPT-3のようなモデルがタスクに特化した微調整なしで様々なタスクで優れたパフォーマンスを発揮できるようにすることを目指しています。

スケーラビリティの検証:

提案された解決策を検証するために、研究者たちは1750億のパラメータを持つGPT-3と呼ばれる自己回帰型言語モデルに対するトレーニングおよび評価実験を行いました。これらの評価は、様々な自然言語処理(NLP)タスクにわたり、モデルの柔軟性と異なる課題に対する汎用性を示しています。

有望な結果の達成:

評価結果は、GPT-3が有望な結果を達成し、微調整されたモデルによって達成された最先端を時折上回ることを示しています。これらの成功は、few-shot learning、one-shot learning、zero-shot learningなど、さまざまな学習シナリオで観察されます。

GPT-3の主な実績:

- Few-shot Learningの実現: GPT-3は、few-shot learningにおいて印象的な実績を達成しました。これは、わずかな例文(few-shot)だけでなく、新しいタスクにも柔軟に適応できることを示しています。これにより、特定のタスクに対して大量のトレーニングデータが不要であるという利点が生まれています。

- 大規模なスケーリングアップ: GPT-3は、1750億のパラメータを持つ非常に大規模なモデルであり、これによってタスクに特化した微調整なしで多岐にわたるタスクにおいて卓越したパフォーマンスを発揮できることを示しています。これはスケーラビリティと柔軟性の向上を象徴しています。

- 汎用性の示唆: GPT-3の評価実験は、様々な自然言語処理タスクにおいて汎用性が高いことを示唆しています。モデルは異なる文脈や課題にも適応でき、その柔軟性が実用的な価値を提供しています。

- 最先端の性能の上回り: GPT-3は、微調整されたモデルに匹敵するか、時折、最先端の性能を上回ることを実証しています。これは、大規模かつ汎用的なモデルが広範なタスクにおいて有望な結果をもたらす可能性を示しています。

GPT-3のこれらの実績により、自然言語処理や機械学習の分野において新たな可能性が開かれ、多岐にわたる応用領域での進展が期待されています。

7. FAQ

BERTとXLNetは自然言語理解にアプローチする方法でどのように異なりますか?

BERTは両方向のコンテキストを考慮することによって言語を理解しようとする一方で、XLNetは自己回帰事前学習法を使用して、入力シーケンスのすべての順列にわたってコンテキストを理解できるようにします。

XLNetとRoBERTaは両方ともBERTの改善を目指していますが、彼らを異ならせる特徴は何ですか?

XLNetは主に全順列にわたる自己回帰事前学習法に焦点を当てていますが、RoBERTaはトレーニング時間の拡張や次の文予測のターゲットを削除するなど、さまざまな最適化を採用しています。これらの違いにより、彼らのBERT最適化のアプローチには重要な違いがあります。

PaLMとGPT-3はどのように異なるアプローチを採用していますか?

PaLMはPathwaysシステムを使用して密なデコーダー専用のTransformerモデルを設計し、トレーニングを大規模なTPU v4 Pods上で行います。これに対して、GPT-3はスケーリングアップとfew-shot learningに焦点を当て、柔軟性と汎用性を向上させ、さまざまな自然言語処理タスクに適応することを目指しています。

ALBERTとGPT-3はそれぞれどのような成果を達成していますか?

ALBERTは最適化されたパラメータ削減手法を採用し、GLUE、RACE、SQuADなどのベンチマークで最先端の成績を達成しています。一方、GPT-3はfew-shot learningとスケーリングアップに焦点を当て、幅広いタスクで優れた柔軟性と性能を発揮し、テキスト生成、自動要約、コード生成などの領域で優れた結果を達成しています。

8. 結論

結論として、NLPモデルの景観は人工知能の進路に重要な影響を与える動的な領域であり、探索された六つのモデル—BERT、XLNet、RoBERTa、ALBERT、PaLM、およびGPT-3—は、NLPの進化においてそれぞれ独自の強みと能力を貢献しています。AIプロジェクトに最適なNLPモデルを選択する際には、プロジェクトの範囲、データセットの特性、および具体的なトレーニング要件など、さまざまな要因が影響します。

これらのモデルの複雑な詳細を探索する中で、これらは単に機械学習の能力を向上させるだけでなく、知識とリソースへのアクセスを民主化していることが明らかになります。AIの民主化は、実践者と研究者の多様なコミュニティを育成し、革新を促進し、全体としてフィールドを前進させます。NLPモデルの持続的な進化は、人工知能にとって興奮する未来を約束し、デジタル時代において情報とのやり取りの方法を再定義する可能性があります。私たちの今後の記事で、NLPモデルを使用したAIプロジェクトの最適化についての詳細な洞察をお楽しみに。これらの最先端のNLPソリューションの変革的な力を受け入れることで、AIに対する理解を高めましょう。

9. NLP model を活用した最新の技術に興味がある方々へ

Miichisoft は、ベトナムのテクノロジー企業として、クロスプラットフォーム開発で数々の成功事例を積み重ねています。私たちは150以上の成功したプロジェクトを通じて培った実績をもとに、ITプロジェクトのリーダーシップに自信を持ち、お客様のビジネス成功に貢献できることを誇りに思っています。

最新のChatGPTを活用した「dxGAI Business | Enterprise」は、Retrieval-Augmented Generation(RAG)モデルを使用した包括的なAIソリューションです。この先進的なソリューションは、最先端の情報統合技術を提供し、企業がRAGモデルを効果的に活用してビジネスプロセスを革新するサポートもMiichisoftが提供しています。

RAG が生成AIの風景を再構築する方法について詳しくは、こちらの参考記事をお読みください。

最新の NLP model やその他のAI技術に興味をお持ちの方々、Miichisoftはお客様がこれらの最新技術をビジネスに組み込む際のパートナーとしてサポートします。安全かつ効果的に活用したい場合は、ぜひお気軽にご連絡いただき、一緒にビジネスコラボレーションの機会を検討しましょう。Miichisoftは、NLP modelを活用した革新的なビジネスソリューションを共に築くための信頼できるパートナーとしてお手伝いします。